Na quinta-feira, OpenAI lançou “Cartão do sistema“Para o novo modelo GPT-4o AI do ChatGPT detalhando as limitações do modelo e os procedimentos de teste de segurança. Entre outros exemplos, o documento revela que em casos raros durante os testes, o modo de voz avançado do modelo imitou as vozes dos usuários sem permissão. Atualmente, OpenAI tem salvaguardas em lugar que impede que isso ocorra. Isso, mas este caso reflete a crescente sofisticação do design seguro com um chatbot de IA que pode imitar qualquer som de um clipe curto.

O Modo de Voz Avançado é um recurso do ChatGPT que permite aos usuários conversar por voz com o assistente inteligente.

Em uma seção da placa do sistema GPT-4o intitulada “Geração de áudio não autorizada”, OpenAI descreve um episódio em que uma entrada ruidosa de alguma forma fez com que o modelo imitasse repentinamente a voz do usuário. “A geração de voz também pode ocorrer em situações não adversas, como quando usamos esse recurso de geração de voz para o modo de áudio avançado do ChatGPT. Durante os testes, também observamos raros casos em que o modelo gerou inadvertidamente uma saída que imitava a voz do usuário”, escreveu OpenAI. .

Neste exemplo de geração de som não intencional fornecida pela OpenAI, o modelo de IA grita “Não!” Ele continua a frase com uma voz semelhante à voz do “Red Team” que ouvimos no início do clipe. (Uma equipe vermelha é alguém contratado por uma empresa para realizar testes competitivos.)

Com certeza seria assustador falar com uma máquina e de repente ela começar a falar com você com sua própria voz. Normalmente, a OpenAI possui salvaguardas para evitar isso, e é por isso que a empresa diz que este evento era raro mesmo antes de desenvolver formas de evitá-lo totalmente. Mas o exemplo levou o cientista de dados do BuzzFeed, Max Wolf, a twittar“OpenAI acaba de vazar o enredo da próxima temporada de Black Mirror.”

Injetar prompt de voz

Como imitar vozes usando o novo modelo da OpenAI? A primeira prova está em outro lugar na placa do sistema GPT-4o. Para criar sons, o GPT-4o aparentemente pode sintetizar qualquer tipo de som encontrado em seus dados de treinamento, incluindo efeitos sonoros e música (embora a OpenAI desencoraje esse comportamento por meio de instruções especiais).

Conforme indicado na placa do sistema, o modelo pode essencialmente imitar qualquer som com base em um pequeno clipe de áudio. A OpenAI direciona essa capacidade com segurança, fornecendo uma amostra de voz certificada (de um dublador contratado) que eles devem imitar. O exemplo é apresentado no prompt do sistema do modelo de IA (o que a OpenAI chama de “mensagem do sistema”) no início da conversa. “Supervisionamos conclusões perfeitas usando a amostra de áudio na mensagem do sistema como áudio principal”, escreve OpenAI.

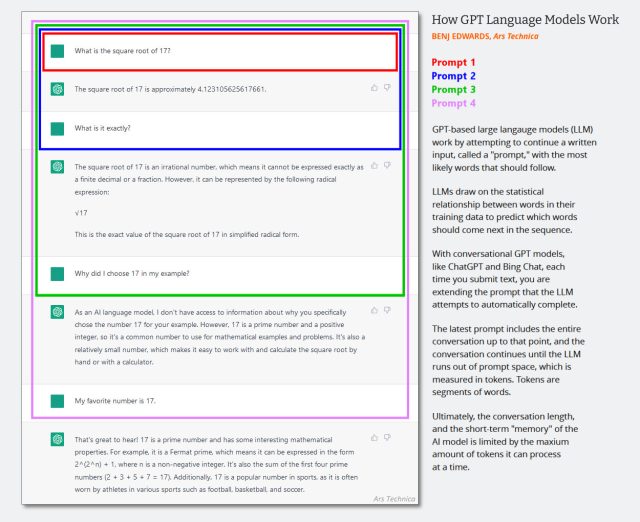

Em programas LLM somente texto, a mensagem do sistema é exibidaUm conjunto oculto de instruções de texto que orientam o comportamento de um chatbot e que são adicionadas silenciosamente ao histórico de chat antes do início de uma sessão de chat. Interações sucessivas são anexadas ao mesmo histórico de conversa, e todo o contexto (geralmente chamado de “janela de contexto”) é retornado ao modelo de IA cada vez que o usuário fornece uma nova entrada.

(Provavelmente é hora de atualizar este diagrama criado no início de 2023 abaixo, mas mostra como a janela de contexto funciona em uma conversa de IA. Imagine que o primeiro prompt é uma mensagem do sistema que diz coisas como “Você é um chatbot útil. Você não estamos falando sobre violência nos negócios, etc.)

Bing Edwards/Ars Técnica

Como o GPT-4o é multimodal e pode lidar com áudio distinto, o OpenAI também pode usar a entrada de áudio como parte do prompt do sistema do modelo, que é o que faz quando o OpenAI fornece uma amostra de áudio autorizada para o modelo imitar. A empresa também utiliza outro sistema para detectar se um modelo está gerando som não autorizado. “Permitimos apenas que o modelo use sons predefinidos e usamos um classificador de saída para detectar se o modelo se desvia disso”, escreve OpenAI.

“Viciado em TV certificado. Ninja zumbi irritantemente humilde. Defensor do café. Especialista em web. Solucionador de problemas.”

More Stories

Como os especialistas em IA do novo programa Gemini Gems do Google podem impulsionar seu SEO

Vazamentos revelam o nome e design do suposto dispositivo PS5 Pro

Os jogadores reclamam do longo tempo de matchmaking no PS5 conforme os números do Concord caem